L'intelligence artificielle :

Hier, aujourd'hui... et demain

Jean-Paul Haton

S'il y a un domaine des sciences du numérique qui a connu une expansion foudroyante dans les dernières décennies, c'est bien l'intelligence artificielle, au point qu'elle est partout aujourd'hui ! Nous revenons ici sur son histoire pour mieux comprendre les défis qui nous attendent dans les années à venir...

Image par Gerd Altmann de Pixabay, CC0.

Introduction

L'intelligence artificielle (IA) est contemporaine de l'informatique. Elle est née au cours des années 1950, avec de jeunes chercheurs tels que John McCarthy, Marvin Minsky [1], Claude Shannon. À la même époque, le mathématicien anglais Alan Turing [2] posait la question centrale qui attend toujours une réponse : « Une machine peut-elle penser ? ».

L'IA est un domaine de recherche-développement (R&D) qui cherche à reproduire sur une machine les processus perceptifs et cognitifs de l'animal ou de l'humain (raisonnement, prise de décision, reconnaissance de formes : parole, images). On parle maintenant d'IA au pluriel. Une IA est un artefact visant à résoudre un problème spécifique tel que reconnaître la parole, traduire un texte, etc.

La naissance « officielle » de l'IA fut précédée d'une longue période de gestation. Les développements théoriques et pratiques sur les automates d'une part, et les travaux en logique mathématique d'autre part, en constituent les fondements.

L'IA s'est ensuite développée en se fondant sur trois grands types de modèles : les modèles symboliques, les modèles statistiques et les modèles connexionnistes. Ces modèles sont brièvement rappelés ci-dessous. L'utilisation des modèles génératifs pose des questions juridiques et éthiques abordées à la fin de cet article.

Les modèles d'IA

Les modèles symboliques

Dès l'apparition de l'ordinateur, des chercheurs émirent l'hypothèse qu'il était possible d'automatiser des raisonnements à l'aide d'algorithmes généraux fondés sur un ensemble de règles logiques appliquées à des structures symboliques, à la suite des travaux sur la logique mathématique. Les systèmes formels ont montré leurs limites intrinsèques (en particulier avec les travaux de Gödel et de Church) pour la modélisation du raisonnement. La nécessité de restreindre un raisonnement à un champ d'application bien délimité et d'appuyer ce raisonnement sur des connaissances variées est ainsi apparue rapidement en IA. Cette approche symbolique de l'IA a donné lieu aux systèmes experts ou systèmes à bases de connaissances, avec de nombreuses réalisations pratiques limitées dans l'industrie, le domaine bancaire ou la médecine. Cette IA symbolique a été particulièrement active au cours des années 1980, avant de laisser la place aux méthodes numériques.

Les modèles statistiques

Ces modèles présentent un cadre formel pour représenter la variabilité inhérente au monde réel. Ces modèles, tout comme les modèles neuromimétiques présentés ci-dessous, sont capables d'apprendre à partir d'exemples, et l'apprentissage consiste ici à mémoriser des distributions de probabilité à l'aide d'algorithmes souvent complexes mais dont les propriétés sont parfaitement connues.

Un modèle statistique bien répandu est celui des réseaux bayésiens [3]. Ces réseaux sont des graphes constitués de nœuds représentant les concepts d'un domaine et d'arcs représentant des relations de causalité probabilisées entre deux concepts (par exemple, tel état patho-physiologique d'un patient peut être la cause de tel symptôme, avec telle probabilité). Un réseau bayésien permet de mener un raisonnement probabiliste sur des faits multiples grâce à des mécanismes de propagation de probabilités à travers le réseau. Il est ainsi très intéressant dans des problèmes à choix multiples tel que le diagnostic, notamment médical.

Le temps est une dimension essentielle dans de nombreuses activités en IA. Ainsi, les modèles statistiques intégrant la variabilité temporelle, ou modèles stochastiques, comptent parmi les plus utilisés en IA. Le modèle stochastique le plus courant est le modèle de Markov caché [4], ou MMC (Hidden Markov Model, ou HMM en anglais). C'est le cas en reconnaissance de la parole où chaque entité à reconnaître est représentée par une source de Markov capable d'émettre le signal vocal correspondant à cette entité [voir la référence 3 en bibliographie]. Un modèle de Markov caché est caractérisé par un double processus stochastique : un processus interne, non observable et un processus externe observable. Ces deux chaînes se combinent pour former le processus stochastique. La reconnaissance revient alors à calculer la vraisemblance de la suite d'observations acoustiques constituant l'entité à reconnaître (mot, unité phonétique) par rapport à chacun des modèles appris. Le modèle présentant la plus grande vraisemblance d'avoir émis cette suite d'observations fournit la réponse.

Un des intérêts des MMC réside dans l'automatisation de l'apprentissage des différents paramètres et distributions de probabilités du modèle à partir de données acoustiques représentatives de l'application considérée. Cet apprentissage est assuré par des algorithmes itératifs d'estimation des paramètres, en particulier l'algorithme de Baum-Welch [5].

Les MMC ont également été utilisés avec succès dans d'autres domaines que la parole, en particulier l'interprétation d'images, la reconnaissance de l'écriture, l'interprétation de signaux (radar, sonar, biologiques, etc.) ou la robotique. Ces modèles étaient une composante centrale des systèmes de reconnaissance de la parole avant l'apparition des réseaux neuronaux profonds.

Les modèles neuronaux ou connexionnistes

Une approche, que l'on peut qualifier de connexionniste, a existé de façon concomitante dès le début de l'IA au cours des années 1950. Elle revient à s'inspirer du fonctionnement du cortex cérébral. L'entité de base est un modèle du neurone, un système étant formé par l'interconnexion d'un grand nombre de tels « neurones » (le modèle le plus courant est le neurone formel proposé par McCulloch et Pitts en 1943, toujours présent dans les systèmes actuels). Il s'agit d'une modélisation très rudimentaire du fonctionnement du neurone, dans laquelle l'accumulation des activités synaptiques du neurone est assurée par une simple sommation pondérée. L'interconnexion d'un ensemble de telles unités fournit un système connexionniste neuromimétique, appelé aussi réseau neuronal, qui présente des propriétés intéressantes. La principale de ces propriétés est certainement la capacité qu'a le réseau d'apprendre à partir d'exemples. Diverses architectures ont été proposées dans ce cadre : réseaux à couches, cartes auto-organisatrices, réseaux récurrents, etc.

|

Notons quelques grandes étapes dans l'évolution des modèles neuronaux :

En 1943, nous avons vu que W. Mc Culloch et W. Pitts proposent un modèle formel du neurone encore présent dans tous les systèmes neuronaux actuels. En 1957 F. Rosenblatt conçoit le perceptron monocouche, réseau neuronal avec simplement deux couches de neurones : une couche d'entrée et une couche de sortie. En 1986 Y. Le Cun et D.E. Rumelhart proposent séparément le perceptron multicouches, extension du perceptron monocouche, et l'algorithme associé d'apprentissage par rétropropagation du gradient d'erreur qui permet d'optimiser les poids des connexions entre les neurones des différentes couches du modèle. Dans les années 2000, apparaissent les réseaux neuronaux profonds caractérisés par un nombre important de couches cachées (jusqu'à plusieurs centaines). Ces réseaux obtiennent des performances exceptionnelles, parfois supérieures à l'humain. - Vers 2015, l'IA générative, fondée sur les réseaux neuronaux profonds, apparaît dans les domaines de l'image, du son et du texte (cf. partie sur l'IA générative).

|

Un concept clé : l'apprentissage

L'apprentissage, caractéristique fondamentale de l'intelligence, est partie prenante de la plupart des systèmes d'IA, quel que soit leur modèle. Dès 1959, Arthur Samuel [6], un des pionniers de l'IA, introduit le terme d'« apprentissage automatique » [7] (Machine Learning).

En ce qui concerne les modèles neuronaux, l'algorithme de rétropropagation du gradient [8] d'erreur a permis le développement dans les années 1990 de modèles neuronaux comportant quelques couches cachées. Depuis, le nombre de couches cachées a été considérablement augmenté, tout en conservant la capacité d'apprentissage à partir d'exemples. Cela a donné naissance aux réseaux neuronaux profonds, Deep Neural Nets, DNN [voir la référence 1 en bibliographie]. Vers 2010, des résultats spectaculaires dans de nombreux domaines : jeu de Go, interprétation d'images, reconnaissance de la parole, traitement de la langue naturelle écrite, diagnostic, ont eu un grand retentissement médiatique.

Les algorithmes d'apprentissage utilisaient initialement des fonctions sigmoïdes comme fonctions non linéaires pour transmettre le résultat du traitement de l'erreur d'une couche à la suivante. L'utilisation d'autres fonctions telles que ReLU (Rectified Linear Unit) et leurs variantes, a permis un gain en performance et en temps très important.

Les progrès de l'IA depuis les années 2010 sont dus à l'utilisation de méthodes numériques d'apprentissage profond (Deep Learning). L'apprentissage profond [9] nécessite à la fois trois conditions qui se sont trouvées réunies dans cette période :

des algorithmes performants (amélioration de la rétropropagation du gradient d'erreur), des moyens de calcul parfois considérables (avec des processeurs spécialisés et l'évolution technologique), la disponibilité de quantités importantes de données d'apprentissage, notamment les Big Data, ces données numériques que nous produisons tous quotidiennement de façon massive (messages vocaux et écrits, signaux GPS, informations climatiques, achats, transactions bancaires, publications scientifiques, journaux et revues, etc.).

Parmi les méthodes d'apprentissage, l'apprentissage par renforcement [10] occupe une place à part. Le principe est d'apprendre par essais et erreurs comment se comporter dans des environnements incomplètement connus. Cette situation est très commune dans la réalité et elle est très utilisée en robotique dès les années 1990, comme dans l'algorithme de Q-Learning [11]. Imaginons un robot se déplaçant dans un univers qu'il cartographie au fur et à mesure. Il peut décider de mener un ensemble d'actions qui lui apporteront éventuellement une récompense. Une action de l'agent conduit à un nouvel état de l'environnement dans lequel il peut mener une nouvelle action qui conduit à un nouvel état, etc. L'environnement est le plus souvent stochastique, ce qui signifie que le nouvel état est aléatoire et n'est connu qu'à travers des probabilités.

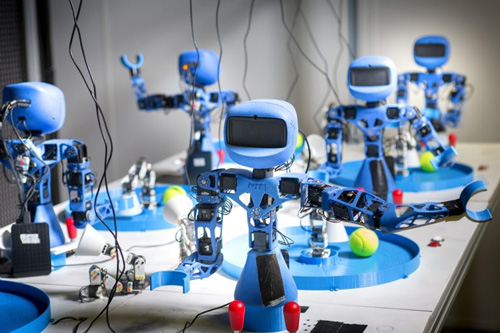

Chacun des six Poppy Torso doit apprendre de façon autonome en explorant ce qu'il y a autour de lui pour manier les manettes. Quand le robot est lancé il ne sait rien au début ; mais il est doté d'un algorithme de curiosité (curiosity driven learning), il se choisit des buts lui-même : par exemple, il constate la présence d'un joystick, il essaie de le bouger, s'il ne se passe rien il essaie autre chose. Il y a une part d'aléatoire au début, puis le robot s'adapte en fonction de ce qu'il arrive à faire et mesure lui-même son progrès. Chaque mouvement dure cinq secondes, il choisit le mouvement suivant en fonction de ce qu'il a fait avant. Les joysticks permettent de bouger le robot blanc (ergo-robot) qui peut alors attraper la balle. C'est le même algorithme sur les six, Poppy Torso, mais chacun va évoluer différemment ; l'apprentissage peut être différent, mais au bout de quelques heures ils arrivent tous au même stade. Le fait d'en avoir six permet de tester différentes versions de l'algorithme pour l'améliorer. Crédit Photo : © Inria / C. Morel.

On peut faire le parallèle avec la théorie comportementaliste en psychologie : l'être humain apprend progressivement à interagir avec le monde, en fonction des rétroactions positives et négatives qu'il reçoit.

Il existe de très nombreuses variantes de l'apprentissage par renforcement, en général formalisées dans un cadre probabiliste. Il est largement utilisé dans le domaine des jeux, notamment le poker (comme les systèmes Libratus [12] et Pluribus de l'Université Carnegie-Mellon en 2019).

L'exemple d'AlphaGo Zéro [13], devenu champion du monde de Go après avoir battu le champion chinois Ke Jie en 2017, est très représentatif. Pour apprendre à jouer, ce logiciel a reçu comme seules connaissances les règles du jeu. En jouant un très grand nombre de parties aléatoires contre lui-même, avec un apprentissage par renforcement, il a battu les meilleurs joueurs humains, tout en inventant des coups originaux.

Les travaux les plus récents tendent à élargir l'apprentissage par renforcement en diversifiant le type de récompense. Dans AlphaGo, le signal de récompense est binaire (gagné-perdu à la fin de la partie). Il peut être nécessaire de définir un ensemble de récompenses plus riche, en général défini par le concepteur humain. On introduit ainsi la notion de motivation intrinsèque, utile dans différents domaines d'activité.

Une méthode analogue a été utilisée pour les jeux vidéo classiques Atari 2600. À partir des pixels et des scores de jeu, sans aucune autre explication, le système a appris à jouer et atteint des performances comparables à celles de joueurs professionnels. Cette approche de l'apprentissage a été confortée par des résultats d'observations sur le cerveau humain. Quand on soumet des personnes à une influence externe de façon à orienter leur comportement ou leur opinion, on observe que les réponses de neurones dopaminergiques (impliqués dans le circuit de la récompense du cerveau) ressemblent à la variable de récompense utilisée dans les modèles numériques.

L'IA générative

Les modèles génératifs d'IA sont les modèles neuronaux capables de créer des données nouvelles : images, vidéos, musiques, textes, à partir d'une invite, brève description textuelle (appelée aussi prompt). Les productions de tels modèles sont très souvent difficilement discernables des contenus réels.

Ce domaine est apparu au début des années 2020. Il a déjà donné des résultats spectaculaires mais va encore beaucoup évoluer.

Nous présentons ci-dessous trois grands types de modèles génératifs :

les réseaux antagonistes (GAN) : ce modèle comporte deux réseaux neuronaux placés en compétition. Un des deux réseaux crée une certaine production (image, texte ou autre type de donnée), et le second réseau a pour rôle de juger la production du premier. Cette production est similaire à des exemples présentés lors de l'apprentissage, mais elle est originale. les modèles de diffusion : une alternative aux GAN pour la génération d'images, telle que l'on trouve dans les systèmes DALL.E 2 [14], StableDiffusion, Imagen [15] ou Midjourney, apparus en 2022, est celle des modèles de diffusion probabiliste. Le formalisme sous-jacent est celui des chaînes de Markov [16]. L'idée est de détruire systématiquement la structure des données d'entrée par additions successives de bruit gaussien, puis d'apprendre à reconstituer ces données en renversant le processus de bruitage. les réseaux transformeurs : ces réseaux apparus en 2017 ont révolutionné le traitement de la langue naturelle écrite. Avant leur apparition, les modèles de langue utilisés en IA étaient essentiellement basés soit sur des modèles statistiques, introduits au cours des années 1980, les modèles n-grammes, soit sur des réseaux neuronaux récurrents, notamment les LSTM ou Long Short-Term Memories. Cela permettait des applications de qualité, comme des robots de conversation ou des logiciels de traduction, mais ces modèles butaient sur une limitation majeure. En effet, pour produire le mot suivant d'une conversation ou d'une traduction, le contexte pris en compte par ces modèles avait une profondeur limitée à un petit nombre n de mots précédents (n étant de l'ordre de 5). Le tournant radical est venu d'un nouveau modèle de réseaux de neurones appelé transformeur. L'apport des transformeurs est d'augmenter considérablement cette profondeur, jusqu'à prendre en compte des milliers de mots. Ces modèles ont ouvert la voie à la création de modèles de langue actuels de grande taille (Large Language Models ou LLM).

L'architecture des réseaux transformeurs a été proposée pour la traduction automatique puis étendue à d'autres champs du traitement de la langue naturelle. En 2018, deux modèles dont l'influence a été décisive ont été développés : BERT de Google (Bidirectional Encoder Representations from Transformers, Encodeur Bidirectionnel à partir de Transformeurs) et GPT d'Open AI (Generative Pretrained Transformer, Transformeur Génératif Pré-entrainé), premier réseau transformeur pré-entraîné et utilisable pour différentes tâches de traitement de la langue naturelle.

Les modèles de langage pré-entraînés sont désormais omniprésents dans le traitement du langage naturel. Ces modèles ont été pré-entraînés sur de très gros corpus de textes d'origines très variées et peuvent être adaptés à une application particulière par un apprentissage fin à l'aide de corpus complémentaires de taille plus modeste.

Image par Alexandra_Koch de Pixabay, CCO.

ChatGPT est un agent conversationnel (chatbot) construit initialement sur GPT-3 puis GPT-4 (apparu en 2023). Ce modèle a été entraîné sur un vaste corpus d'extraits du Web correspondant à 600 Go de données (le site Wikipédia, qui fait partie des sources utilisées représente seulement 0,6 % de l'ensemble des données d'apprentissage).

Pour parfaire le système, deux types de modules ont été adjoints :

Un apprentissage par renforcement, en interaction avec des utilisateurs humains, pour améliorer la capacité de conversation, Un contrôle destiné à garantir l'utilisateur du système (usages dangereux ou malveillants, contenus racistes, sexistes ou haineux, biais).

ChatGPT peut ainsi être utile dans de nombreux domaines. Son succès a été foudroyant, avec 100 millions d'utilisateurs dans les deux premiers mois... Mais il faut aussi être conscient de ses limitations actuelles :

les réponses fournies par ChatGPT sont le plus souvent correctes, mais elles peuvent être parfois fausses ; voire absurdes : on parle « d'hallucinations » du système, les réponses fournies sont sensibles à la façon dont le prompt a été rédigé. Il importe donc d'apprendre à interroger efficacement ChatGPT, le système ne connaît que les données sur lesquelles son apprentissage a été effectué.

Le système est purement statistique. Il donne simplement la réponse la plus probable à la question posée et ne dispose d'aucune connaissance de bon sens. ChatGPT enchaîne les mots de façon cohérente, mais sans conscience ni intention. Il a parfois été qualifié de perroquet statistique (plus précisément stochastic parrot).

ChatGPT n'est pas seul sur le marché. L'entreprise chinoise Baidu a également ouvert son robot conversationnel chinois Ernie Bot au grand public. La startup française Mistral a de son côté lancé Le Chat.

La taille des modèles continue de croître de façon spectaculaire. Ainsi, le modèle Megatron-Turing de Microsoft et Nvidia, qui obtient des résultats remarquables pour différentes tâches, contient plus de 500 milliards de paramètres. OpenAI n'a pas publié les caractéristiques techniques de la version 2023 de GPT, appelée GPT-4, mais il est tout à fait possible qu'il comprenne plus de mille milliards de paramètres. Pour ne pas être en reste, la Chine a annoncé le système Wu Dao 2.0, également de type transformeur, et comportant 1 750 milliards de paramètres... Les recherches sont actives en Chine puisqu'en 2022, des chercheurs de l'Université Tsinghua ont développé GLM-130B, un modèle bilingue anglais-chinois surpassant GPT-3 pour différentes tâches.

On constate une croissance exponentielle de la taille des systèmes. Les performances des systèmes croissent avec leur taille, sans qu'il apparaisse pour l'instant une asymptote à cette croissance des performances. Cela réclame bien sûr une très importante puissance de calcul. Mettre au point de tels modèles demande d'utiliser des super-ordinateurs. Enfin, la consommation énergétique très importante et les émissions de gaz à effet de serre associées à l'apprentissage et à l'utilisation de ces modèles devront être optimisées pour favoriser une utilisation généralisée des systèmes.

L'IA générative est également mise en œuvre pour des tâches multimodales impliquant plusieurs types de données : texte, image, vidéo, voix. GPT-4, apparu en mars 2023, va dans ce sens. Ce système est le premier qui accepte en entrée des textes et des images pour produire des textes en sortie. Ce domaine est appelé à se développer à l'avenir car les applications sont nombreuses.

Le domaine des arts (peinture, sculpture, photographie, musique, cinéma) est largement investi par l'IA générative. Le principe demeure le même : à partir d'une base d'apprentissage de grande taille composée d'œuvres d'artistes humains, il s'agit de fournir une production conforme au prompt proposé. De nombreux systèmes sont proposés aux artistes, voire au grand public.

Dans le domaine de l'image, on peut citer les systèmes Stable Diffusion, MidJourney, Dall-E, Imagen ou Lensa. La qualité des productions de tels systèmes est étonnante. Prenons deux exemples parmi beaucoup d'autres :

En 2018, le tableau « Portrait d'Edmond de Bellamy », créé par un système de réseaux antagonistes fut adjugé 432 500 $. En 2022, le Mauritshuis Museum de La Haye, propriétaire du tableau « La Jeune fille à la perle » [17] de Vermeer, a proposé aux artistes d'exposer leurs variations autour de ce tableau pendant que celui-ci était prêté à un autre musée. Parmi les plus de trois mille œuvres proposées, le choix s'est porté sur un tableau créé par un artiste qui a utilisé les logiciels Midjourney et Photoshop.

En musique, l'IA offre aux artistes de nouvelles possibilités de créativité : nouveaux timbres et sonorités, contrôles musicaux inédits, procédés de composition. Un grand nombre de logiciels de composition musicale, souvent open source, existent sur le marché (tels que AI Music, MuseNet, MusicLM, MusicGen...). Ces outils peuvent être des aides remarquables pour les compositeurs humains.

On peut également citer le domaine de la vidéo (bientôt sans doute le cinéma), mais aussi la photographie ou la sculpture.

Un aspect important est celui du droit d'auteur. Les créations de ces systèmes sont déclarées originales, ce qui sous-entend qu'elles seraient libres de droits. Ce n'est pas exact, car on a montré que l'image produite peut parfois être déjà présente dans les images d'apprentissage. Mais quand bien même on filtrerait ces exceptions, la question de la propriété intellectuelle reste litigieuse. En effet, les grandes bases d'images d'apprentissage, comme Flickr, Wikipedia, WikiArt, etc., sont certes accessibles publiquement, mais elles sont soumises au droit d'auteur. Les enjeux économiques de ces créations, ainsi que les enjeux de vie privée, font que le problème n'est pas théorique. Il faut s'attendre à ce que la justice pose des limites.

Par ailleurs, on peut se demander si ces logiciels font réellement preuve de créativité. Sur le plan philosophique, il a été longtemps acquis que la créativité était l'apanage de l'Homme, et que la machine ne pouvait produire que des imitations. L'originalité des œuvres produites depuis les années 2015 par les systèmes d'IA générative remet en cause cette certitude. La question se pose de la place de l'humain dans le processus de création artistique et entre l'artiste et l'IA. Quatre cas sont possibles :

- L'IA est un simple outil.

- Il existe une collaboration entre l'humain et la machine.

- Il s'agit d'une cocréation.

- L'IA est une source d'inspiration.

L'utilisation de logiciels d'IA générative pose des questions juridiques mais aussi éthiques.

Le règlement européen sur l'IA (AI Act) [18] adopté en 2024 veut mieux prendre en compte les IA génératives en leur imposant des règles de transparence. Ces règles concernent la nécessité d'informer clairement l'utilisateur qu'il communique avec une machine, notamment pour les personnes vulnérables (personnes âgées, enfants) susceptibles d'être plus facilement trompées. Ces utilisateurs peuvent ainsi être amenés à prendre des décisions ou suivre des recommandations biaisées. Par ailleurs, les entreprises développant des systèmes d'IA générative seraient tenues de préciser si les données utilisées pour développer leurs systèmes sont protégées par des droits d'auteur (textes scientifiques, musiques, photos, etc.). En ce qui concerne ces données, l'Europe a déjà émis le règlement général sur la protection des données (RGPD) qui assure la protection de toutes les données à caractère personnel.

Les droits de propriété intellectuelle interviennent également en IA générative. On sait que l'apprentissage des systèmes a été réalisé à l'aide de données collectées sur la Toile. Cela pose des questions relatives au respect du droit de collecte, du respect des droits personnels et de la protection des informations.

L'usage de l'IA générative soulève aussi des questions au sujet de l'auteur d'une œuvre issue de l'IA. Les premiers procès déjà engagés aux USA permettront de mieux éclairer cette délicate question.

Sur le plan de l'éthique [19], l'utilisation de logiciels tels que ChatGPT pose la question de réponses éventuellement biaisées. En effet, les modèles d'IA peuvent être biaisés en fonction des données utilisées pour l'apprentissage. Ces biais peuvent être involontaires et difficiles à détecter ; ils peuvent avoir des conséquences éthiques importantes, concernant notamment la liberté d'expression lorsqu'ils sont utilisés pour la modération de contenu en ligne, ou la gestion des ressources humaines.

La possibilité d'une action malveillante doit également être prise en compte. Les malfrats peuvent utiliser l'IA générative pour des actions criminelles : commettre un crime, diffuser de la désinformation ou manipuler l'opinion publique.

Regard sur l'avenir

Depuis les années 1950, l'IA a connu des hauts et des bas... tout en restant essentiellement confinée aux laboratoires de recherche.

L'IA générative, apparue vers 2015, a suscité l'intérêt des médias. Elle est désormais présente dans de nombreux domaines et utilisée par un très large public.

Les systèmes d'IA apportent à l'humain une aide intelligente pour la création (artistique, littéraire, industrielle) et la communication. Les domaines concernés sont variés et leur nombre ne cesse de croître : enseignement, journalisme, art, justice, commerce, finance, publicité, informatique, médecine, transports...

Mais les utilisations frauduleuses ou criminelles sont hélas également présentes : désinformation, rédaction de textes ou d'articles scientifiques, spams, messages haineux, etc. Une régulation est nécessaire pour éviter tous les abus. L'Europe est à la pointe de ce combat avec le RGPD puis la loi sur l'IA, AI Act. Mais les réactions sont variées selon les pays.

L'histoire ne s'arrête pas là et les systèmes d'IA générative sont appelés à beaucoup évoluer dans les années à venir dans différentes directions :

- Qualité des réponses (cf. l'évolution de chatGPT-3 à 4),

- Généralisation de systèmes multimodaux mariant textes, images et sons,

- Intégration aux moteurs de recherche « classiques » (cf. Bard de Google) et aux systèmes de bureautique (cf. Copilot de Microsoft) et à la conception (cf. Firefly d'Adobe).

Mais il faut aussi rester conscient que ces systèmes sont loin d'être parfaits. Ils ne sont que des outils statistiques évolués qu'il faut apprendre à utiliser en connaissant leurs capacités et leurs limites. Par ailleurs la recherche fondamentale continue car de nombreuses voies restent à explorer :

La capacité d'explication des réseaux neuromimétiques : ces systèmes sont essentiellement des boîtes noires dont le fonctionnement interne est mal connu. Le manque de capacités de compréhension et de bon sens des systèmes actuels. L'IA symbolique permettra peut-être de progresser dans ce domaine. L'IA doit rester un outil au service de l'humain. L'interaction humain-machine doit être plus étudiée.

On est encore loin d'égaler l'intelligence humaine, en admettant qu'on l'atteigne un jour, car une accumulation d'IA étroites ne produit pas une IA générale. L'objectif initial des jeunes chercheurs américains au début des années 1950 était non seulement de construire des machines intelligentes au service de l'humanité, mais aussi de mieux saisir ce qu'est l'intelligence. Cette double ambition reste pertinente et passionnante.

Jean-Paul Haton

agrégé de l'Université en physique

(École Normale Supérieure de Saint-Cloud)

docteur d'État ès Sciences,

professeur émérite en informatique à l'Université de Lorraine

(Faculté des Sciences et Technologies de Nancy)

Publié le : 31 mai 2024 sur )I( Interstices.

https://interstices.info/lintelligence-artificielle-hier-aujourdhuiet-demain/

Cet article est sous licence Creative Commons Attribution 4.0 International.

https://creativecommons.org/licenses/by/4.0/deed.fr

Bibliographie

Le Cun Yann. Quand la machine apprend, la révolution des réseaux de neurones et l'apprentissage profond. Éditions Odile Jacob (2021).

Haton Jean-Paul. et al. Intelligences artificielles : de la théorie à la pratique. Éditions Dunod (2023).

Haton Jean-Paul. La parole numérique. Académie Royale de Belgique, Collection Poche, n° 79 (2016).

NOTES

[1] https://interstices.info/marvin-minsky-un-pere-visionnaire-de-lintelligence-artificielle/

[2] https://interstices.info/alan-turing-du-concept-a-la-machine/

[3] https://interstices.info/les-reseaux-bayesiens/

[4] https://fr.wikipedia.org/wiki/Modé8le_de_Markov_caché

[5] https://fr.wikipedia.org/wiki/Algorithme_de_Baum-Welch

[6] https://fr.wikipedia.org/wiki/Arthur_Samuel

[7] https://interstices.info/glossaire/apprentissage-automatique/

[8] https://fr.wikipedia.org/wiki/Rétropropagation_du_gradient

[9] https://interstices.info/glossaire/apprentissage-profond/

[10] https://fr.wikipedia.org/wiki/Apprentissage_par_renforcement

[11] https://fr.wikipedia.org/wiki/Q-learning

[12] https://fr.wikipedia.org/wiki/Libratus

[13] https://interstices.info/programmation-des-echecs-et-dautres-jeux/

[14] https://www.louisbouchard.ca/blog-ia/dalle-2

[15] https://www.louisbouchard.ca/blog-ia/google-brain-imagen

[16] https://interstices.info/glossaire/chaine-de-markov/

[17] https://fr.wikipedia.org/wiki/La_Jeune_Fille_à_la_perle

[18] https://artificialintelligenceact.eu/fr/high-level-summary/

[19] https://interstices.info/quelle-ethique-pour-les-agents-conversationnels/

|